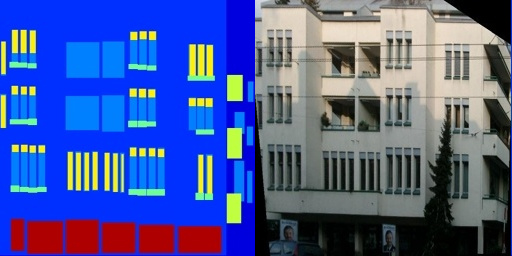

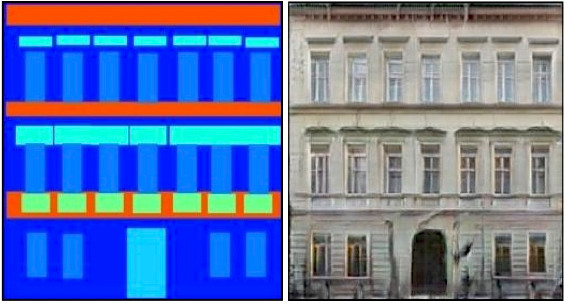

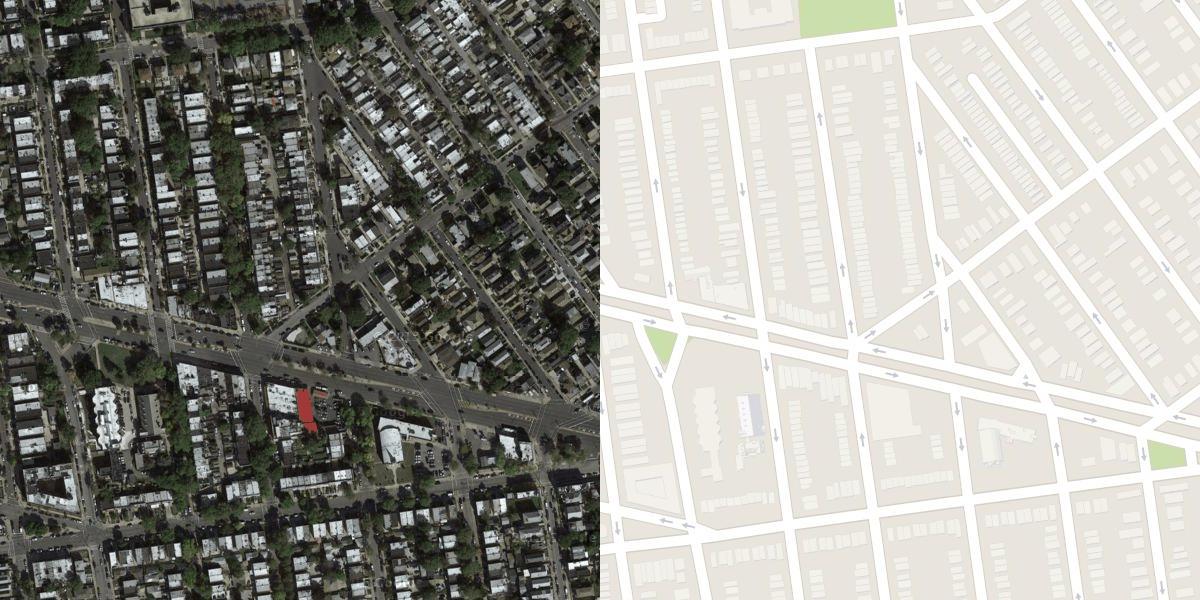

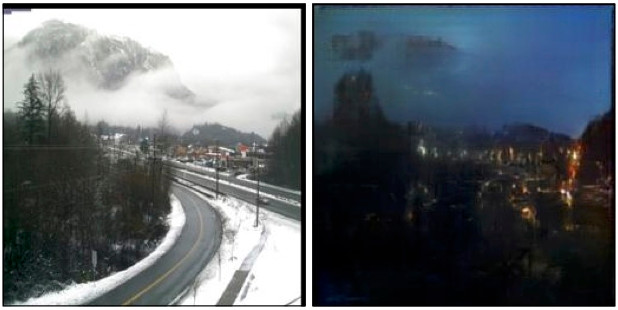

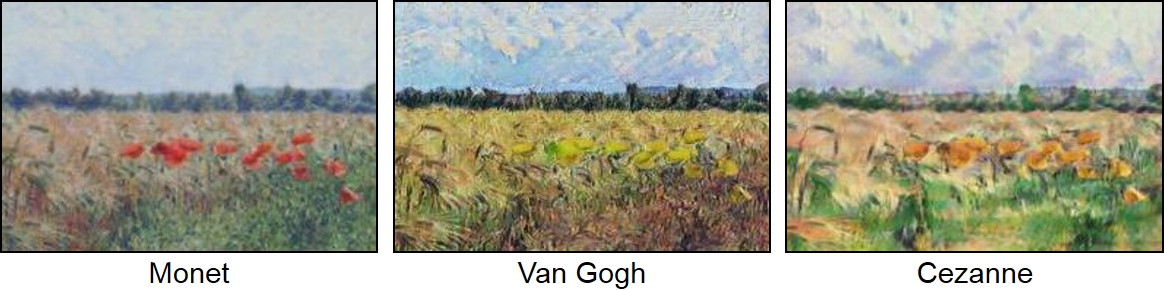

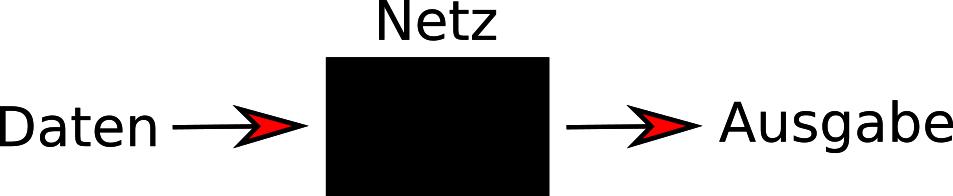

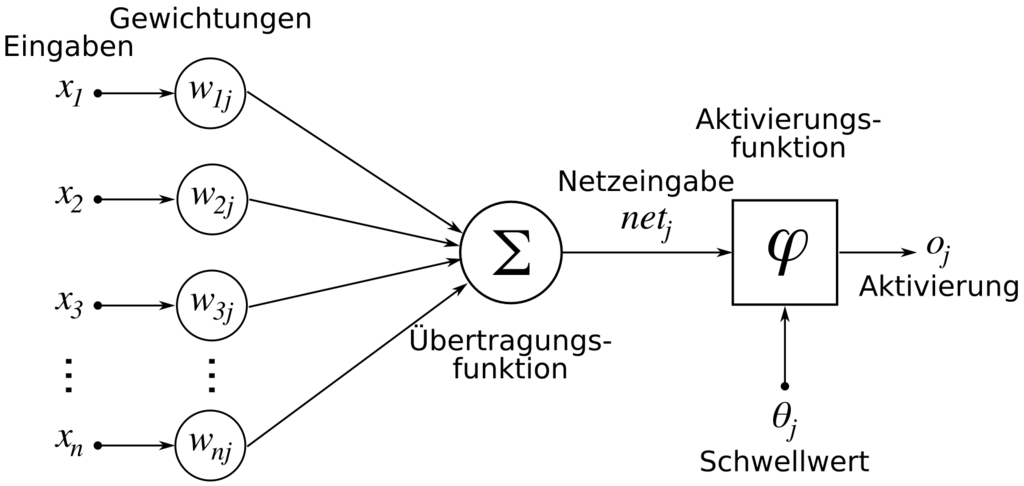

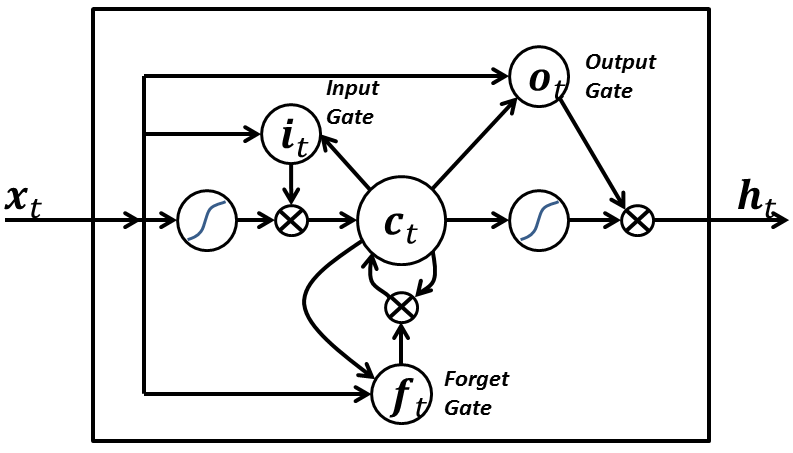

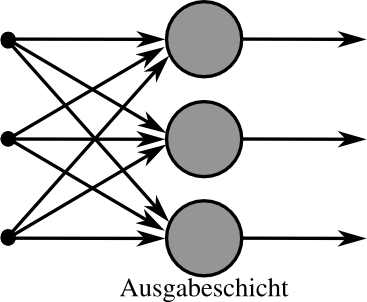

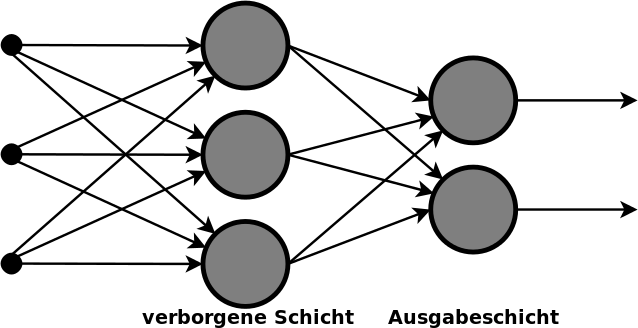

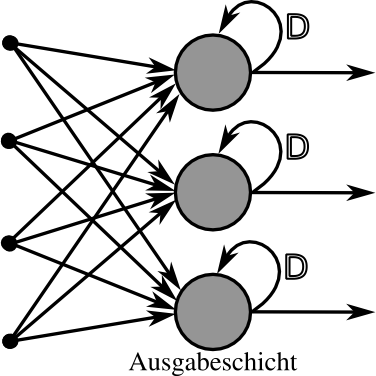

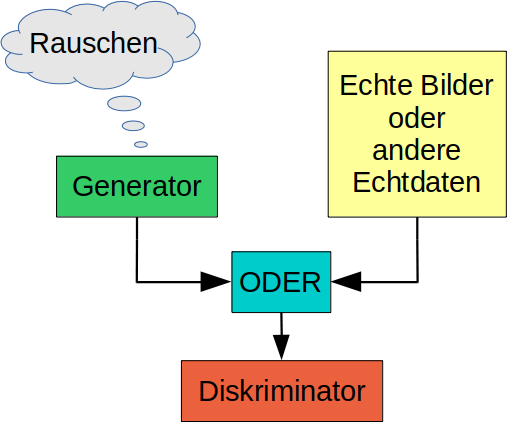

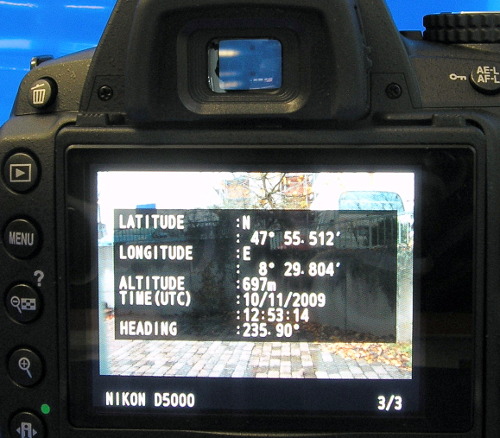

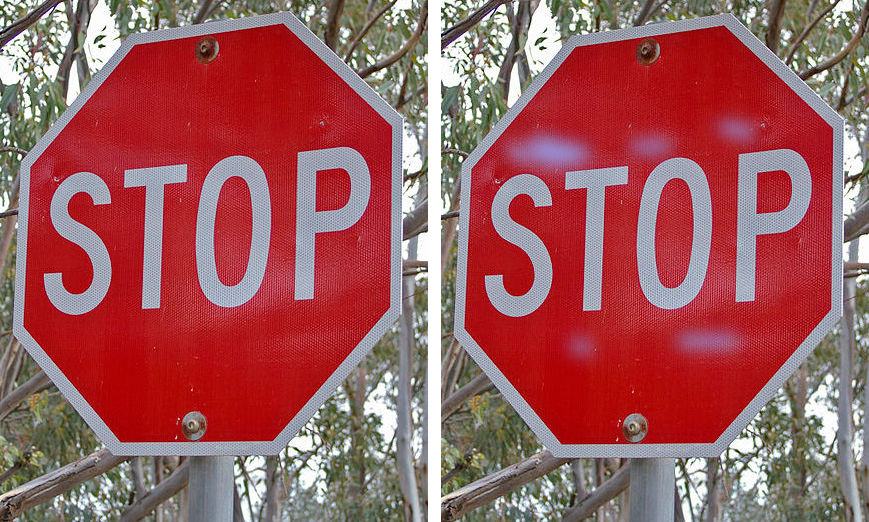

class: center, middle # Künstliche Intelligenz ### Zwischen Faszination und Ernüchterung #### Hauke Goos-Habermann --- ### Über mich / den Vortrag - Bin Entwickler des Softwareverteilungssystems m23, biete Support zu Linux und Freier Software - Bin am Thema "KI" interessiert ohne ein Anwendungszenario zu haben - Meine Interessen - Die Grundlagen hinter *sogenannter KI* - Aktuelle freie KI-Frameworks - Handfeste Beispielprojekte mit vorzeigbaren Ergebnissen - Grenzen und weitere Überlegungen - Der Vortrag ist eine subjektive Auswahl von Punkten, die mich interessieren oder mir wichtig erscheinen --- ### Meine Zeitleiste - 1996: IBMs <b>Deep Blue</b> (1996: 216 spezielle VLSI-Schachprozessoren, 36 **GB** Ram, 144 GB Festplatte. 1997: 480 Prozessoren, 30 GB Ram, 120 GB Festplatte) schlägt den damals amtierenden Schachweltmeister Garri Kasparow erstmalig beim Schach und probiert ca. 126 Millionen Stellungen pro Sekunde durch. .copyright[Aus <a href="https://de.wikipedia.org/wiki/Deep_Blue">de.wikipedia.org/wiki/Deep_Blue</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] Zum Vergleich: Mit 8 **MB** Ram waren PCs 1996 gut ausgestattet, 16 und mehr waren eher Luxus. Festplatten waren zwischen 850 MB und 2,5 GB üblich. - 199?: Ein Schulkamerad erzählt, daß er ein künstliches neuronales Netz implementiert hat. - 1996/1998: <i>"Das Konzept des Spieles <b>Creatures</b> ist es, Kreaturen, meist sogenannte Norns, zu züchten. Die Kreaturen im Spiel besitzen ein verhältnismäßig weit entwickeltes neuronales Netzwerk, zusätzlich wird ein biochemisches System und eine DNA simuliert, um die „Kreuzung“ zwischen Kreaturen zu ermöglichen. [...]<br> Die Spieleengine von Creatures 2 (1998) war so leistungsstark, dass die britische Armee darauf aufmerksam wurde und diese kurzerhand 1998 ein Projekt starteten, in dem die Norns das <b>Bedienen und Fliegen von Eurofightern</b> erlernten."</i> .copyright[Aus <a href="https://de.wikipedia.org/wiki/Creatures_(Spieleserie)">de.wikipedia.org/wiki/Creatures_(Spieleserie)</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] --- ### Meine Zeitleiste - 199?/200?: Für ein Computerrennspiel fanden die Entwickler keinen guten Algorithmus, um die Autos auf der Ideallinie fahren zu lassen. Stattdessen entwarfen, trainierten und verwendeten sie ein (kleines) künstliches neuronales Netzwerk. - 2015: <i>"<b>DeepDream</b> ist eine Software [...] aus dem Bereich Computer Vision, die auf dem Prinzip eines künstlichen neuronalen Netzes basiert. Dabei wird ein Convolutional Neural Network (faltendes neuronales Netzwerk), das eigentlich der Erkennung und Klassifizierung von Inhalten in Bildern dient, zur Veränderung des eingegebenen Bildes verwendet, wobei Strukturen in das Bild eingefügt werden, die beispielsweise Hunden oder Gebäuden ähnlich sehen."</i> .cls[ .copyright[Aus <a href="https://de.wikipedia.org/wiki/DeepDream">de.wikipedia.org/wiki/DeepDream</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ]   --- ### Meine Zeitleiste - 2016: CeBIT: Japanische Universität stellt Ki-Projekte vor: Z.B. eine Gurkensortiermaschine, die Gurken fotografiert, mit <b>Tensorflow</b> kategorisiert und mit einem Schieber in verschiedene Behälter schubst. - 2017: <b>pix2pix</B>: Transformation von einem Ursprungsbild zu einem Zielbild. .cls[ .copyright[z.B. <a href="https://github.com/phillipi/pix2pix">github.com/phillipi/pix2pix</a> (<a href="https://github.com/phillipi/pix2pix/blob/master/LICENSE">BSD</a>)] ] - 2017 (deutsche Variante 2018): <i>"<b>Common Voice</b> ist ein von Mozilla gestartetes Crowdsourcing-Projekt zur Erstellung einer freien Datenbank für Spracherkennungs-Software. Das Projekt wird von Freiwilligen unterstützt, die Beispielsätze mit einem Mikrofon einsprechen und Aufnahmen anderer Nutzer überprüfen. Die transkribierten Sätze werden in einer Stimm-Datenbank gesammelt [...]."</i> .cls[ .copyright[Aus <a href="https://de.wikipedia.org/wiki/Common_Voice">de.wikipedia.org/wiki/Common_Voice</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] - 2017: Parallel zu Common Voice entwickelt Mozilla die Spracherkennungs-Engine <b>DeepSpeech</b>, eine TensorFlow-Implementierung der DeepSpeech-Architektur von Baidu. --- ### Meine Zeitleiste - 2019: <i>"Im Januar 2019 wurde <b>AlphaStar</b> vorgestellt, ein KI-Programm, das das Echtzeit-Strategiespiel StarCraft II spielt. [...] <br> In zwei Sätzen zu je fünf Spielen gegen die professionellen Spieler Dario „TLO“ Wünsch und Grzegorz „MaNa“ Komincz gewann AlphaStar jedes Spiel. [...] <br> Besondere Stärken von AlphaStar waren Micromanagement und Multitasking, wurde aber im letzten Spiel durch ungewöhnliche Aktionen des menschlichen Spielers [MaNa] aus dem Tritt gebracht."</i><br> .copyright[Aus <a href="https://de.wikipedia.org/wiki/DeepMind#AlphaStar">de.wikipedia.org/wiki/DeepMind#AlphaStar</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)]<br> Mitschnitte, Analysen, Kommentare und weitere Demonstrationen sind auf YouTube verfügbar. Suchworte: "alphastar starcraft 2". - 2019: <b>Population Based Training</b>: Gleichzeitiges Trainieren von vielen zufällig aufgebauten Netzen (Typ und Tiefe) zum Finden der "optimalen" Zusammenstellung (Hyperparameter). Gut funktionierende Netze tauschen ihre Hyperparameter aus, um die Ergebnisse der abgeleiteten Netze weiter zu optimieren.<br> .copyright[<a href="https://deepmind.com/blog/population-based-training-neural-networks">deepmind.com/blog/population-based-training-neural-networks</a>] --- ### Wer hat's erfunden? * 1943: McCulloch-Pitts-Zelle * 1950: Alan Turing macht Vorschlag für ein neues "Fachgebiet der künstlichen Intelligenz" * 1956: Als Gründungsveranstaltung der Künstlichen Intelligenz als akademischem Fachgebiet gilt die Dartmouth Conference im Sommer 1956 * Ende der 1960er Jahre entwickelte Joseph Weizenbaum (1923–2008) vom MIT mit einem relativ simplen Verfahren das Programm ELIZA, in dem der Dialog eines Psychotherapeuten mit einem Patienten simuliert wird. * ... Viele Theorien, Gedanken und Abhandlungen, aber praktische Anwendung schwierig. .cls[ .copyright[Aus <a href="https://de.wikipedia.org/wiki/Geschichte_der_k%C3%BCnstlichen_Intelligenz">de.wikipedia.org/wiki/Geschichte_der_k%C3%BCnstlichen_Intelligenz</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] --- ### Warum kommt KI erst jetzt ins Rollen? * Viel Rechenleistung verfügbar: Parallele Berechnung auf (mehreren) Grafikkarten oder Spezialchips wie Googles TPUs (Tensor Processing Unit) * Viele Trainingsdaten frei verfügbar: Große kategorisierte (Bilder-)Datensätze können heruntergeladen werden * OpenSource-Frameworks verfügbar: z.B. TensorFlow (Google), Torch (Facebook) oder Keras, welches verschiedene Backends nutzen kann. * Viele Beispielprogramme verfügbar: Auf GitHub, GitLab und anderen Seiten. Suchworte z.B.: tensorflow, keras, gan, cnn, cyclegan oder lstm. * Ki-Baukästen: Cloudfirmen bieten (vereinfachte) Weboberflächen zum Zusammenklicken von KNN, Hochladen von Trainingsdaten, dem Trainieren und Anwenden an. --- ### Was kann man damit machen? - <b>Kategorisierung</b>: z.B. Bilder automatisch mit Stichworten versehen oder den Handlungsverlauf in Videos erkennen und als Text beschreiben. - <b>Bildtransformationen</b> mit direkter Entsprechung: z.B. Zeichnung zu Foto (pix2pix), Satellitenbilder zu Vorschlägen für OpenStreetMap-Karten (mapwith.ai) - <b>Bildtransformationen <i>ohne</i></b> direkte Entsprechung: z.B. Stil von Malern auf Fotos übertragen oder Pferde in Zebras umwandeln - <b>Spracherkennung</b> (DeepSpeech), automatische <b>Übersetzungen</b>, ... - <b>Generierung</b> von Inhalten: z.B. Gesichter, Katzen, fotorealistische Fahrräder, Autos oder Hotelzimmer, Bildauflösung vergrößern und dabei Details hinzuerfinden, Level für Computerspiele, Musikstücke (z.B. magenta.tensorflow.org), Töne, Wetterberichte, Artikel, Drehbücher usw. - Gute KI-Gegner für Computerspiele - ... --- ### Kategorisierung  * Hund: 99% * Katze: 0,7% * Maus: 0,3% .cls[ .copyright[Bild: <a href="https://www.flickr.com/photos/cogdog/29763655890/">cogdogblog</a> / <a href="https://creativecommons.org/publicdomain/zero/1.0/deed.en">Creative Commons CC0 1.0</a>] ]  * Hund: 95% * Katze: 4,7% * Maus: 0,3% .cls[ .copyright[Bild: <a href="https://de.wikipedia.org/wiki/Datei:Tchiorny_Terrier.jpg">Stephan Czuratis</a> / <a href="https://creativecommons.org/licenses/by-sa/2.5/deed.de">Creative Commons BY-SA-3.0 de</a>] ] Projekt z.B. <a href="https://github.com/xblaster/tensor-guess">https://github.com/xblaster/tensor-guess</a> --- ### Bildtransformationen mit direkter Entsprechung Fassaden anhand eines Bauplanes zusammensetzen  Trainingsdaten (Paare von Ursprungs- und Zielbild) .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] .cls[  Anwendung des trainierten Netzes .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] ] --- ### Bildtransformationen mit direkter Entsprechung Luftbilder in Straßenkarte umwandeln  Trainingsdaten (Paare von Ursprungs- und Zielbild) .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] .cls[  Anwendung des trainierten Netzes .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] ] --- ### Bildtransformationen mit direkter Entsprechung  Anwendung des trainierten Netzes Umriß in fotorealistisches Bild umwandeln .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] .cls[  Anwendung des trainierten Netzes Tageslichtaufnahme in Nachtbild umwandeln .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] ] --- ### Bildtransformationen mit direkter Entsprechung  Anwendung des trainierten Netzes Schwarzweißbild in Farbaufnahme umwandeln .copyright[Bild: <a href="https://github.com/affinelayer/pix2pix-tensorflow">github.com/affinelayer/pix2pix-tensorflow</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] --- ### Bildtransformationen mit direkter Entsprechung .cls[  Eingabebild .copyright[Bild: <a href="https://de.wikipedia.org/wiki/Datei:Hauskatze_filou.jpg">Nicolai Schäfer</a> / <a href="https://creativecommons.org/licenses/by-sa/2.0/de/deed.de">CC-BY-SA-2.0-de</a>] ] .cls[  Erwünschtes Ergebnis .copyright[Bild: <a href="https://de.wikipedia.org/wiki/Datei:2012.05.12_MALBORK_(4).JPG">Kozak1410</a> / <a href="https://creativecommons.org/licenses/by-sa/3.0/pl/deed.de">CC-BY-SA-3.0-pl</a>] ] .cls[  Errechnete Ausgabe ] --- ### Bildtransformationen ohne direkte Entsprechung .copyright[Bilder: <a href="https://github.com/junyanz/CycleGAN">github.com/junyanz/CycleGAN</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] Nachempfundene Malstile  --- ### Bildtransformationen ohne direkte Entsprechung Pferd in Zebra umwandeln  .copyright[Bild: <a href="https://github.com/junyanz/CycleGAN">github.com/junyanz/CycleGAN</a> / <a href="https://github.com/affinelayer/pix2pix-tensorflow/blob/master/LICENSE.txt">MIT</a>] --- ### Generierung von Inhalten 32x32-Pixel-Katzen  .copyright[Bilder: <a href="https://github.com/aleju/cat-generator">github.com/aleju/cat-generator</a> / <a href="https://github.com/aleju/cat-generator/blob/master/LICENSE">MIT</a>] 32x32-Pixel-Gesichter  .copyright[Bilder: <a href="https://github.com/aleju/face-generator">github.com/aleju/face-generator</a> / <a href="https://github.com/aleju/face-generator/blob/master/LICENSE">MIT</a>] --- ### Die Grundidee  Das KNN soll aus Eingabedaten die gewünschten Ausgabedaten erzeugen - Beim Training werden Daten ins Netz geben und dieses solange angepaßt, bis die Ausgabe dem gewünschten Ergebnis ähnlich genug ist. - Beim Anwenden des trainierten Netzes werden Daten hineingeben und die Ausgabe verwenden. --- ### Eine künstliche Zelle  .cls[ .copyright[Aus <a href="https://de.wikipedia.org/wiki/Datei:ArtificialNeuronModel_deutsch.png">de.wikipedia.org/wiki/Datei:ArtificialNeuronModel_deutsch.png / Chrislb</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] Hierbei müssen alle nötigen Informationen zu jedem Zeitpunkt verfügbar sein. --- ### Langes Kurzzeitgedächtnis (LSTM) <br> .copyright[Bild: <a href="https://de.wikipedia.org/wiki/Datei:Long_Short_Term_Memory.png">de.wikipedia.org/wiki/Datei:Long_Short_Term_Memory.png / BiObserver</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] LSTM-Zellen sind deutlich komplexer aufgebaut und können selbstständig Informationen für spätere Durchläufe speichern und wieder verwerfen. Sie werden bei Aufgabenstellungen eingesetzt, bei denen nicht alle Informationen zum benötigten Zeitpunkt vorliegen. So ergibt sich der Sinn von gesprochenen Worten beispielsweise erst aus den aufeinanderfolgenden Lautfolgen und dem Kontext. --- ### Von der Zelle zum Netz Neben diesen beiden Zellentypen gibt es weitere, wie unter <a href="https://de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz#Klassen_und_Typen_von_KNN">de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz#Klassen_und_Typen_von_KNN</a> beschrieben. Mehrere Zellen (graue große Kreise) können zu einem Netz zusammengefügt werden. Z.B. zu einem einschichtigen Netz:<br> .cls[ .copyright[Aus <a href="https://de.wikipedia.org/wiki/Datei:SingleLayerNeuralNetwork_deutsch.png">de.wikipedia.org/wiki/Datei:SingleLayerNeuralNetwork_deutsch.png / Chrislb</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] --- ### Zweischichtiges Netz  .cls[ .copyright[Aus <a href="https://de.wikipedia.org/w/index.php?title=Datei:Multi-Layer_Neural_Network-Vector.svg">de.wikipedia.org/w/index.php?title=Datei:Multi-Layer_Neural_Network-Vector.svg / Offnfopt</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] --- ### Rekurrentes Netz (RNN)  .cls[ .copyright[Aus <a href="https://de.wikipedia.org/w/index.php?title=Datei:Multi-Layer_Neural_Network-Vector.svg">de.wikipedia.org/w/index.php?title=Datei:Multi-Layer_Neural_Network-Vector.svg / Offnfopt</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] --- ### Faltendes neuronales Netzwerk (CNN)  * Über das Eingabebild (Graustufenbild) mit der Kernel-Matrix wandern * Jeden Bildpunkt (Zahl zwischen 0-255) des Eingabebildes mit dem dazugehörigen Gewicht aus der Kernel-Matrix multiplizieren * Summe aller Produkte bilden und in Zielmatrix eintragen .cls[ .copyright[<a href="http://www.martina-nolte.de">www.martina-nolte.de / Martina Nolte</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] ] <!-- ### Max pooling <br> .copyright[Bild: <a href="https://de.wikipedia.org/wiki/Datei:Max_pooling.png">de.wikipedia.org/wiki/Datei:Max_pooling.png / Aphex34</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] <i>"Max pooling mit einem 2×2-Filter und Schrittgröße = 2. Die Schrittgröße gibt an wie viele Pixel der Filter pro Operation verschoben wird. Präventionsmaßnahme gegen Overfitting, verringerter Platzbedarf und erhöhte Berechnungsgeschwindigkeit. Möglichkeit zur Erzeugung tieferer Netzwerke."</i><br>.copyright[Aus <a href="https://de.wikipedia.org/wiki/Convolutional_Neural_Network">de.wikipedia.org/wiki/Convolutional_Neural_Network</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] --> --- ### Von einfachen zu tiefen Netzen Diese "Grundnetze" können miteinander kombiniert und mehrfach hintereindergesetzt werden, um ein tiefes Netz aufzubauen. - Mit wachsender Größe der einzelnen Schichten und der Tiefe steigen der Berechnungsaufwand und der Speicherbedarf beim Trainieren und Anwenden des Netzes. - Abhängig von den eingesetzten Zellen (z.B. bei LSTM) steigt der Ressourcenbedarf nochmals erheblich. - Nicht jeder Zelltyp ist für jede Aufgabe geeignet. - Die Dimensionierung des Netzes muß zur Aufgabenstellung passen. --- ### Training * <i>"Beim <b>überwachten Lernen</b> wird dem KNN ein Eingangsmuster gegeben und die Ausgabe, die das Neuronale Netz in seinem aktuellen Zustand produziert, mit dem Wert verglichen, den es eigentlich ausgeben soll. Durch Vergleich von Soll- und Istausgabe kann auf die vorzunehmenden Änderungen </i>[Stichwort: Fehlerrückführung/Backpropagation] <i>der Netzkonfiguration geschlossen werden."</i>*<br><br> Frameworks wie TensorFlow verschieben (auf geschickte Weise) die Gewichtungen der Zellen, um eine möglichst geringe Abweichung von Soll- und Istausgabe zu erreichen. * Liegen keine Paare aus Ein- und gewünschter Ausgabe vor, so können durch <b>bestärkendes Lernen</b> positive (auch nur zufällige) Ergebnisse eines KNN "belohnt" bzw. negative "bestraft" werden werden. Dies können bei einem Computerspiel das Erhöhen des Punktestandes bzw. der Verlust eines Lebens sein. \*.copyright[Aus <a href="https://de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz">de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] --- ### Training: Bildtransformationen mit direkter Entsprechung <b>Überwachtes Lernen</b> mit dem Ziel: Kategorisierung oder Umwandlung eines Eingabebildes in ein Ausgabebild * Paare aus Eingabebild und gewünschter Ausgabe bilden die <b>Trainingsdaten</b>, um ein künstliches neuronales Netzwerk zu trainieren. * Da das <b>Zielbild</b> jeweils bekannt ist, kann die <b>Abweichung</b> von errechnetem und gewünschtem Ergebnis bestimmt und das Netz dementsprechend angepaßt werden. * Weitere Paare, die nicht zum Trainieren verwendet werden, dienen zum Überprüfen des Lernerfolges. --- ### Training: Generierung von Bildern  * <b>Bestärkendes Lernen</b> am Beispiel eines erzeugenden gegnerische Netzwerke (GAN) * Das <i>Generator</i>-Netz erzeugt aus zufälligem Rauschen neue Bilder. * Durch eine <i>ODER</i>-Weiche werden Bilder vom Generator oder aus einer Liste mit echten Bildern an den Diskriminator weitergeleitet. * Das <i>Diskriminator</i>-Netz soll nun entscheiden, ob das Bild aus der Liste oder dem Generator stammt. * Irrt sich der <i>Diskriminator</i> in seiner Einschätzung, ob die ODER-Weiche ein echtes oder generiertes Bild an ihn weitergeleitet hat, wird sein Netz entsprechend angepaßt. * Deckt der Diskriminator eine Fälschung vom Generator auf, so wird das Generator-Netz entsprechend angepaßt. --- ### Grenzen - Schlechte, unpassende oder einseitige Trainingsdaten führen zu schlechten Ergebnissen. - Zu wenig Trainingsdaten führen zu schlechten Ergebnissen oder zum "Auswendiglernen". - Zu große Netze sind zu langsam oder passen nicht in den Speicher. - Zu kleine oder unpassend gestaltete Netze passen nicht zum angedachten Answendungsfall und führen zu schlechten Ergebnissen. - Zu wenig optimierte Netze sind zu langsam beim Training und der Anwendung. - Nachvollziehbarkeit der Ergebnisse von Netzen aufgrund der Komplexität nicht oder nur eingeschränkt möglich. --- ### Schlechte Trainingsdaten Wenn Trainingsdaten zu viele gleichartige Beispiele oder Beispiele ohne "markante" Details enthalten, "lernen" die KNN daraus falsche Zusammenhänge: * links: "Leuchtturm" .copyright[(<a href="https://de.wikipedia.org/wiki/Datei:Futters%C3%A4ule1.jpg">Hajotthu</a> / <a href="https://creativecommons.org/licenses/by-sa/3.0/deed.de">CC-BY-SA-3.0</a>)]: Form (Turm) richtig, Kontext falsch * mitte: "Digitale Uhr" .copyright[(<a href="https://commons.wikimedia.org/w/index.php?title=User:YellowShark&action=edit&redlink=1">YellowShark</a> / <a href="https://creativecommons.org/licenses/by-sa/2.0/de/deed.de">CC BY 3.0</a>)]: Details (Ziffern) zu stark gewichtet, Kontext falsch * rechts: "Qualle" .copyright[(<a href="https://de.wikipedia.org/wiki/Datei:Killer_Whale_Family.jpg">Nehrams2020</a> / <a href="https://creativecommons.org/licenses/by-sa/3.0/deed.de">CC-BY-SA-3.0</a>)]: Kontext (Wasser) richtig, Detail (Qualle) fehlt<br>    (Bilder nachempfunden) --- ### Schlechte Trainingsdaten Weitere Beispiele: - <b>Erkennung von Hautkrankheiten auf Fotos</b>: Auf vielen Fotos mit Krankheitsbefund war ein Lineal zu sehen, auf Fotos mit gesunder Haut fehlte es hingegen.<br><br> Erkenntnis für die KI: Lineal = krank, kein Lineal = gesund. - <b>Erkennung feindlicher Einheiten auf Luftbildern</b>: Auf den Trainingsbildern hatten die eigenen Einheiten die Sonne stets im Rücken, sodaß der Schatten immer in dieselbe Richtung zeigte.<br><br> Erkenntnis für die KI: Schatten vor einer Einheit = eigene Einheit, Schatten hinter einer Einheit = feindliche Einheit. - Fazit: - KNN sind "faul" und können sich auf falsche Elemente oder Details konzentrieren, die die Entwickler nicht im Sinn hatten. - Netze lernen komplette Bilder (statt abstrakter Merkmale) auswenig (Overfitting). --- ### Gezielte Täuschung Auch wenn die Trainigsdaten gut waren, so wird das KNN, das Straßenschilder erkennen soll, wahrscheinlich anfällig für gezielte Täuschungen sein. So wird das rechte STOP-Schild, durch die von einem anderen KNN generierten Flecken, als Vorfahrsschild klassifiziert.  (nachgestellt)<br> .copyright[Aus <a href="https://commons.wikimedia.org/wiki/File:STOP_sign.jpg">commons.wikimedia.org/wiki/File:STOP_sign.jpg / Bidgee</a> (<a href="http://creativecommons.org/licenses/by-sa/3.0/legalcode">CC-BY-SA-3.0</a>)] --- ### Trainingsdaten erstellen (bei Google) - Bilder stammen von Streetview oder den Kameras von selbstfahrenden Autos - Beliebig oft wiederholen: 1. Kategorisierung durch Menschen, die reCAPTCHA-Rätsel lösen, in Klassen wie z.B. Autos, Motorräder, Ampeln, Schornsteine, ... 2. Ein (mehrere?) KNN (stetig) mit den neuen Bilder trainieren 3. Klassifizierte Bilder per GAN so modifizieren, daß sie vom KNN in falsche Kategorien einsortiert werden 4. Weiter bei 1. --- ### Was StarCraft II so kompliziert macht * Es liegen nie alle Informationen vor, um das ganze Spielgeschehen zu erfassen (anders als z.B. beim Schach). Informationen müssen aktiv z.B. durch Aufdecken der Karte eingeholt werden. * Es gibt keine optimale, immer gültige Strategie, die für jede Aktion eine perfekte Gegenreaktion beinhaltet. Der Aktionsraum mit hunderten von Einheiten und Gebäuden ist sehr groß. * Um zu gewinnen, muß eine KI das Makromanagement, also das langfristige Vorrausplanen von Aktionen und das Mikromanagement, z.B. das Bewegen, Angreifen und den Rückzug von Einheiten, beherrschen. * Die KI muß schnell reagieren, da alle Aktionen in Echtzeit vorgenommen werden. --- ### Ein komplexes Beispiel: AlphaStar - Training von (Anfangs-)Netzen mit <b>tausenden von Spielverläufen</b> (überwachtes Lernen) mit einer einfachen Oberfläche, die Listen für Einheiten und deren Eigenschaften enthält. Ausgaben sind "Spielzüge". - Von den Anfangsnetzen wurden leicht anders gewichtete Netze (Agenten) erstellt und trainiert, die Partien in der "AlphaStar league" gegeneinander gespielt haben (verstärkendes Lernen). AlphaStar ist insbesondere beim Mikromanagement (Truppenbewegung) sehr gut. - Neue Agenten werden von (erfolgreichen) Agenten abgeleitet und dynamisch zur "AlphaStar league" hinzugefügt (Vererbung). - Die Netze hatten anfangs Zugriff auf die ganze aufgedeckte Karte. Später wurde die "Spielregeln" so geändert, daß die KI immer nur – wie die menschlichen Spieler – einen Kartenausschnitt "sehen" kann. - Jeder Agent wurde in der "AlphaStar league" 14 Tage auf jeweils 16 TPUv3s trainiert. Dies entspricht bis zu 200 Jahren Spielgeschehen in Echtzeit. - Etwas gemogelt: Die Profispieler wußten nicht, daß sie gegen unterschiedlich trainierte KIs spielten. - Genauere (richtigere) Informationen:<br><a href="https://deepmind.com/blog/alphastar-mastering-real-time-strategy-game-starcraft-ii">deepmind.com/blog/alphastar-mastering-real-time-strategy-game-starcraft-ii</a> --- ### Einstieg - Viele Beispiele https://github.com/aymericdamien/TensorFlow-Examples - Einfach mal (auch in Kombination) suchen - Netztypen: DCGAN, GAN, CNN, RNN, LSTM - KI-Frameworks: Tensorflow, Kera, Torch - Zum Ausprobieren im Browser: Jupyter Notebook, IPYNB - Webseiten mit KI-Spielereien - Videos, Tutorials, etc. - Ludwig: Neuronale Netze ohne Code erstellen, trainieren und testen. https://github.com/uber/ludwig --- ### Mein Fazit * KI kann mit heutigen Technologien (Software und Hardware) verblüffende Ergebnisse in *einigen* Disziplinen liefern * Komplexe Problemstellungen sind nur bedingt lösbar * Aktuelle KI-Umsetzungen entsprechen eher hochkomplexen Statistikfunktionen * Wirkliche *Intelligenz* ist nicht vorhanden * Hierfür wären evtl. auch komplett andere Ansätze (oder Kombinationen mit anderen Technologien) nötig --- class: center, middle # Vielen Dank für die Aufmerksamkeit! ## Fragen? <!-- ### Aufzählung 1. Introduction 2. Deep-dive 3. ... ## Mit Punkt - a - b # One-Hot-Encoding ```php <?php $a[0] = 0.1; $ohe[0] = 0; $a[1] = 0.7; $ohe[1] = 1; $a[2] = 0.2; $ohe[2] = 0; for ($i=0; $i < count($a); $i++) ?> ``` # Bilder .right[] .right[<a rel="nofollow" class="external text" href="http://www.martina-nolte.de">Martina Nolte</a> / <a href="http://creativecommons.org/licenses/by-sa/3.0/de/legalcode">Creative Commons BY-SA-3.0 de</a>] -->